L’avènement des objets connectés dans notre quotidien soulève de nombreuses problématiques, notamment en termes de ressources énergétiques et de traitement des données. Le développement de ces technologies nécessite des changements d’approches impliquant les nanotechnologies.

Ce dossier « Vers l’apprentissage automatique embarqué » est proposé en collaboration avec l’Institut des Nanotechnologies de Lyon (INL). Au fil de 3 épisodes, nous vous invitons à explorer les enjeux de l’apprentissage automatique embarqué, les défis scientifiques et technologiques qu’ils soulèvent, et les perspectives offertes par les nanotechnologies dans ce domaine.

Épisode 3 : L'approximation pour adapter les architectures de calcul IA aux applications

Qu’est-ce qu’une architecture de calcul et quel est son rôle ?

On peut imaginer une architecture comme un ensemble des composants reliés entre eux permettant de réaliser des opérations. Si le nombre d’opérations est important on parle d’architecture générique ; c’est ce que l’on retrouve dans les processeurs de nos ordinateurs et téléphones portables par exemple. Si le nombre d’opérations est limité, on parle d’architecture spécifique à une classe d’applications. Les architectures spécifiques sont très optimisées et permettent une grande performance (rapidité de calcul) ainsi qu’une importante efficacité énergétique.

Comment améliorer une architecture de calcul spécifique pour l’IA ?

Les performances d’une architecture de calcul dépendent à la fois du nombre de calculs à réaliser, et des technologies de fabrication de ses composants (les circuits électroniques). C’est ce dernier point qui explique la très grande importance des recherches sur les technologies émergentes menées par l’INL (voir épisode 2). Une autre solution pour améliorer les performances d’une architecture de calcul serait de changer la façon d’utiliser les composants de l’architecture ; c’est-à-dire changer le paradigme de calcul d’une architecture pour améliorer encore davantage sa performance et son efficacité énergétique. La suite de ce numéro présente les travaux en cours à l'INL sur le paradigme de calcul approximatif et ses avantages pour les applications IA.

L’approximation et l’IA

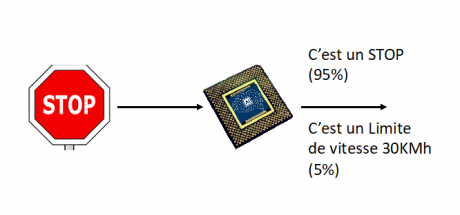

Une application IA est par sa nature une implémentation approximative d’une fonction mathématique. Pour donner un exemple, on peut considérer que la figure ci-dessous représente une application IA pour l’automobile, capable de classifier les panneaux routiers. Dans l’exemple, notre application classifie le panneau comme un signal de STOP avec une confiance de 95 %. Mais dans le même temps elle considère aussi que le panneau représente une limitation de vitesse à 30 Km/H, avec une confiance de 5 %. Le résultat est donc une approximation : plusieurs réponses sont fournies, avec chacune un niveau de confiance. La « bonne » réponse est celle qui présente le meilleur niveau de confiance.

Cet exemple est basé sur une implémentation du classificateur pour une architecture de calcul capable de manipuler des nombres binaires de 32 bit : cela signifie que chaque valeur est représentée par 32 chiffres binaires (0 ou 1). Réduire la taille des nombres de notre architecture à 16 bit, par exemple, a pour effet de manipuler des nombres plus petits, ce qui permet d’obtenir le résultat plus rapidement et avec moins d’énergie. Réduire la taille des nombres a aussi un impact sur la précision des résultats (ils sont davantage approximés), mais l’avantage de l’IA est que cet impact est négligeable grâce à la résilience aux erreurs des calculs. Pour poursuivre sur notre exemple, exécuter les calculs à 16 bit amène à classifier le panneau de STOP avec une confiance de 94 % au lieu des 95 % d’origine. La perte de précision est donc négligeable comparée à la réduction du coût de calcul qui elle est de 50 %.

L’INL travaille à la conception d’architectures de calcul approximées à précision variable pour les rendre adaptables à différentes applications (projet européen APROPOS et projet ANR AdequateDL).

L’IA dans les contextes « critiques »

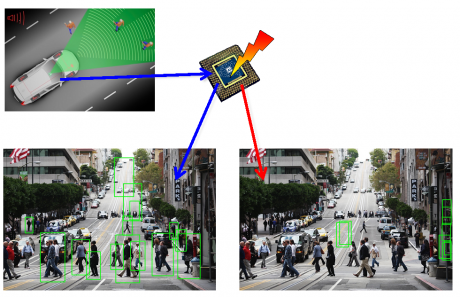

L’efficacité globale d’une application IA peut donc être définie par sa performance et son efficacité énergétique, mais également par sa fiabilité. Ce dernier point est particulièrement important dans les contextes dits « critiques ». Les applications de guide autonome basées sur la détection d’objets en sont un bon exemple, avec notamment le développement de véhicules autonomes où l’erreur n’est pas permise. Néanmoins, tout circuit électronique peut être sujet à des pannes matérielles temporaires et/ou permanentes dues à des défauts de fabrications et/ou à des perturbations externes. Dans la figure ci-dessous, la flèche rouge représente la survenue d’une panne dans l’architecture de calcul et son impact sur le résultat de l’application : aucun piéton est détecté et le système de la voiture accélère considérant que la voie est libre. L’enjeu ici est de rendre l’architecture capable de détecter la présence d’une panne et de la corriger. L’INL est l’un des premiers laboratoires en France à travailler sur la fiabilité des architectures de calcul pour l’IA (projet ANR RE-TRUSTING).

L'IA dans les formations de Centrale Lyon

L'impact récent de la pandémie sur les chaînes d'approvisionnement des semi-conducteurs, la prise de conscience de l'empreinte carbone du traitement des données, et la dépendance mondiale croissante à l'égard des ressources de traitement de l'information, ont renouvelé l'intérêt pour le matériel micronanoélectronique sous-jacent. Ce dernier revêt une importance critique et stratégique pour le développement national et la souveraineté européenne. L'INL et le Groupement de Recherche SOC2 contribuent à la construction du programme national PEPR (Programmes et Équipements Prioritaires de Recherche exploratoires) sur l'IA, avec un focus particulier sur les architectures d'IA embarquées et les technologies émergentes. Les élèves de Centrale Lyon sont également sensibilisés à ces questions sociétales par l’intermédiaire de cours spécifiques et de projets encadrés par les enseignants-chercheurs du laboratoire.

(Re)découvrez les deux premiers épisodes de ce dossier en trois volets. Épisode 1 : Qu’est-ce que l’apprentissage automatique embarqué et pourquoi s’y intéresser ?. Épisode 2 : Les technologies émergentes pour l'IA matérielle écoénergétique.

Ces axes de recherche sur l'apprentissage automatique embarqué sont portés par Ian O'Connor et Alberto Bosio, professeurs à l'École Centrale de Lyon/INL.